블로그를 시작한지 얼마 되지도 않은 것 같은데, 에이블스쿨이 종료되었습니다... 6개월간 같은반 에이블러분들과 힘든일도, 추억도 많았기에 에이블스쿨 졸업 후기를 써보려고 합니다.

○ 병행을 통해 달성한 것

금융 아이디어 공모전 장려상 수상, AICE자격증, 빅데이터 분석기사(필기), ADsP 자격증 취득 을 달성했습니다.

비록 빅데이터 분석기사 실기는 떨어져 아쉽지만, 단기간에 많은 자격증과 공모전 수상까지 했다는 점이 뿌듯하게 다가오네요.이는 아무래도 에이블스쿨 DX커리큘럼 덕분에 '데이터 분석 - IT 인프라 - 제안서 작성' 이라는 컨설턴트 풀스택을 쌓았기에 이뤄낼 수 있었던 결과라고 생각합니다.

에이블스쿨 시작 이전 다짐했던 것들을 모두 달성할 수 없었더라도 금융경력 + IT직무역량 을 실현할 수 있었던 6개월이었기에 보람있던 나날이었습니다.

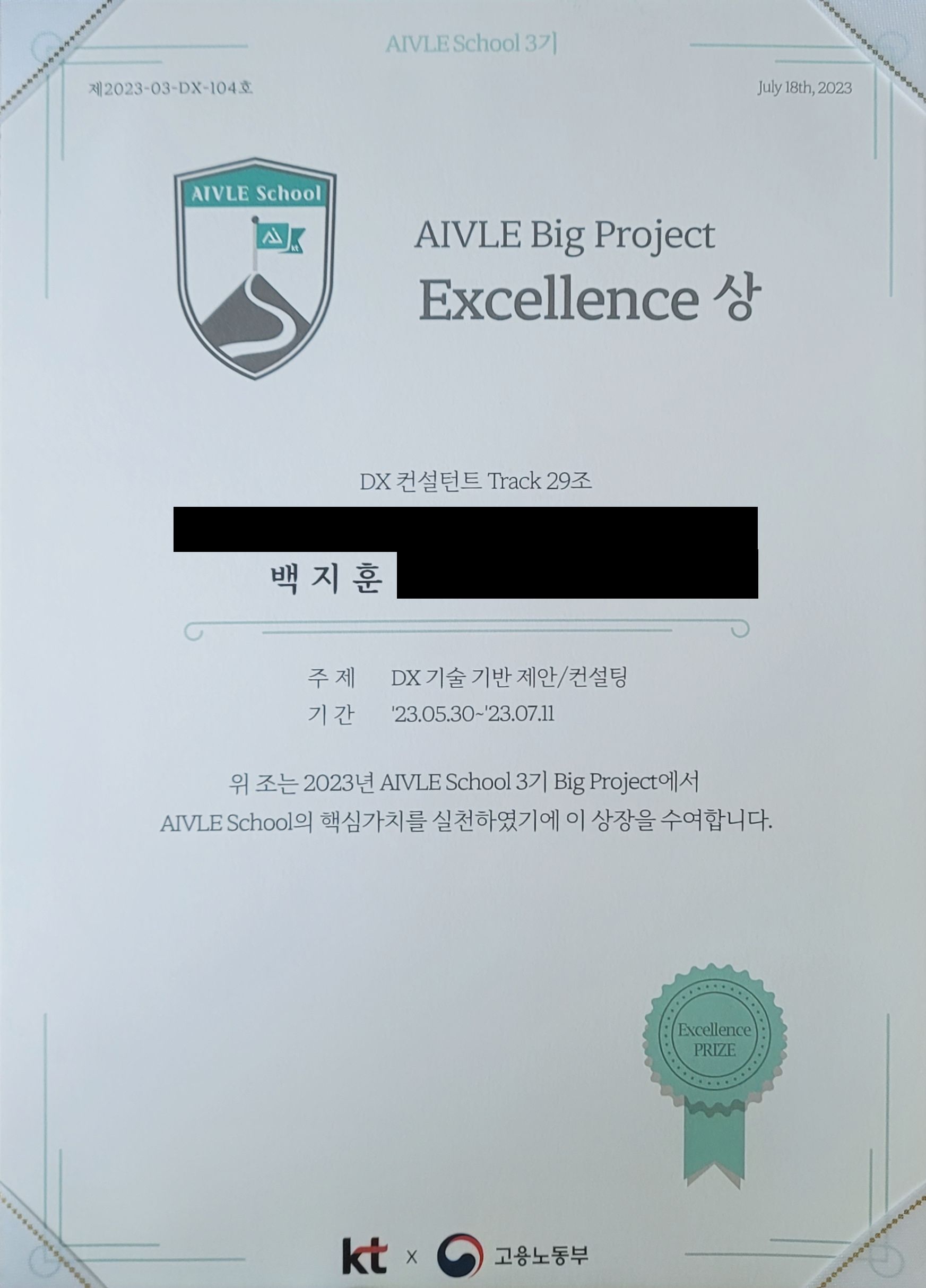

○ 빅프로젝트 결과

저희 조는 '영유아를 위한 행복한 보육환경 조성 솔루션'을 목표로 프로젝트를 진행했지만, 아쉽게도 우수상, 최우수상같은 결과물에 기반한 상을 수상하지는 못했습니다. 자칫 식상하게 보일 수 있는 주제로 접근했고, 저희 조만의 특출난 솔루션이 전달되지 않은 탓이겠지요...

그래도 에이블스쿨 핵심가치인 '실력과 프로정신'을 인정받아 Excellence 상을 수상할 수 있었습니다.

수상내역을 보니, '주제의 창의성', '프로젝트 구현 여부', '제안 PPT', '인프라의 구체적 설명', 'KT 서비스와 기기의 설명' 이 중점으로 이루어졌던 것 같습니다.(물론 제 뇌피셜입니다)

○ 우수 에이쁠 기자단

우수한 에이블러인 'Dean's 에이블러 상', 코딩 마스터즈에서 실력을 발휘하여 받는 '코딩 마스터즈 상', 기자단 및 반장 활동을 열심히 진행해서 받는 '우수 에이쁠 상' 중에서 우수 에이쁠 상을 수상했습니다!!

기자단을 한다고 모두 받는 상도 아니고, 블로그를 꾸준히 업로드한게 아니었어서 사실 어떻게 받았는지 모르겠지만 ㅎㅎ 하나하나 업로드 할때마다 마음을 듬뿍 담아 썼던게 전해지지 않았나 생각합니다.

에이블스쿨 덕분에 난생 처음 블로그도 써보고, 이래저래 새로운 도전을 하면서 많이 격려받은것 같아 고마운 마음이 듭니다. 앞으로도 고-급 기술블로거로 거듭날때까지 이어서 작성해보겠습니다.

○ 잡페어

KT, BC카드, K뱅크, KT cs, 오케스트로 등 굴지의 KT 산하 기업과 협력 기업들이 모여 잡페어를 진행했습니다.

스탬프를 5개 먼저 모으면 캐리어와 같은 선물도 증정했는데 저는 선물보다 잡페어 내용이 더 중요하다고 생각해서 질문지도 많이 만들어갔겠다, 선착순 선물은 애초에 포기하고 시작했지만...

잡페어의 결과는 조금 아쉬웠습니다. 기업들의 채용 의지가 많이 부족해 보였거든요. KT의 경영이슈가 문제인지, 시장상황이 문제인지는 모르겠지만 이래저래 아쉬움을 많이 남겼던 잡페어였습니다.

KT클라우드는 수도권만 진행하고 아예 없기도 했습니다...

○ 요즘 근황은?

7월 18일 마지막 체크아웃과 함께 KT 채용공고가 시작되었습니다. 에이블전형 채용공고이기에 심혈을 기울여서 임할 예정입니다.

1기나 2기 선배분들은 빅프로젝트 중간에 채용공고가 나왔다고 하는데 얼마나 힘들었을지... 4기때는 어떻게 변할지 모르겠습니다.

쉬지않고 달려왔지만, 힘들었다는 기억보다 재미있었다는 추억이 더 많이 남는 6개월이었습니다. 앞으로 저와 함께 DX 컨설턴트의 꿈을 꾸는 차기 에이블러 여러분들께서도 달리는 동안 지치지 않고 꼭 바라는 바를 이룰 수 있는 시간을 만드셨으면 좋겠습니다.

이상 에이블스쿨 관련 블로그 업로드를 마칩니다. 6개월간 물심양면으로 도와주신 모든 에이블러, 에이블스쿨 관계자 여러분 감사합니다.

'AIVLE_School' 카테고리의 다른 글

| 에이블스쿨 DX커리큘럼 - GeoPandas(단계구분도를 그려보자 3) (2) | 2023.06.03 |

|---|---|

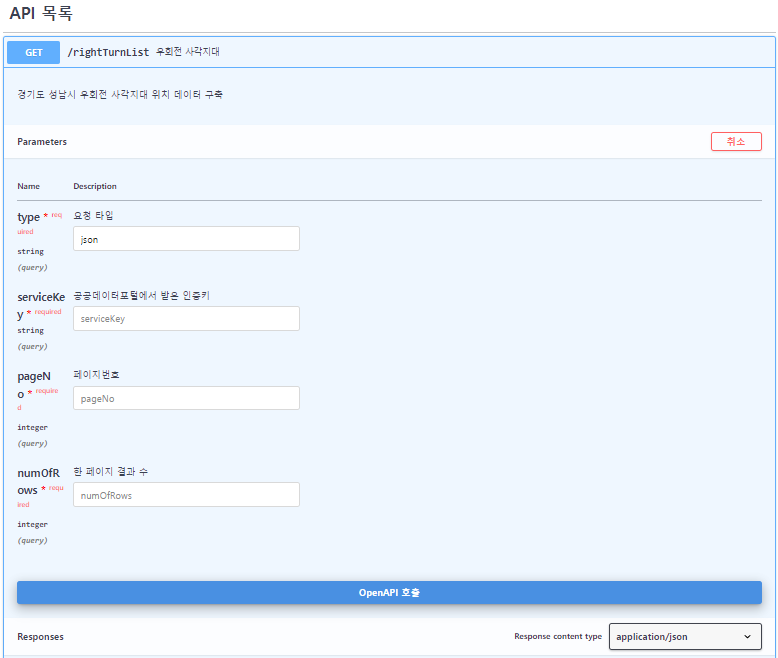

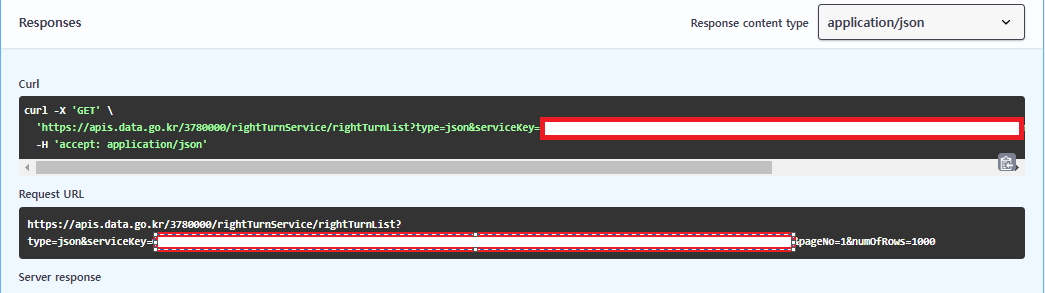

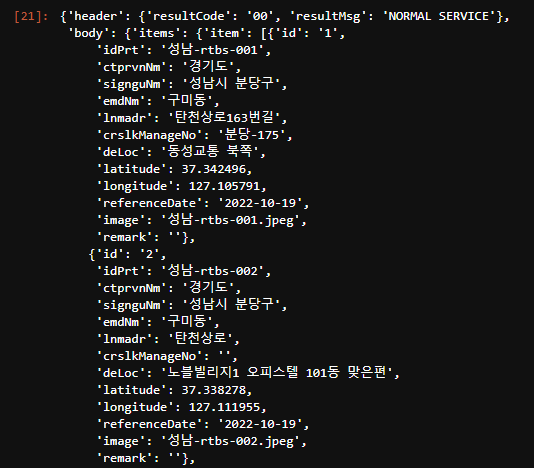

| 에이블스쿨 DX커리큘럼 - 공공데이터포털을 사용해보자 (0) | 2023.06.03 |

| 에이블스쿨 DX커리큘럼 - GeoPandas(단계구분도를 그려보자 2) (0) | 2023.06.02 |

| 에이블스쿨 DX커리큘럼 - GeoPandas(단계구분도를 그려보자 1) (0) | 2023.06.02 |

| 에이블스쿨 DX커리큘럼 - 공모전에 나가보자(금융 데이터 활용 아이디어 경진대회) (2) | 2023.05.31 |